- Auteur Miles Stephen [email protected].

- Public 2023-12-15 23:39.

- Laatst gewijzigd 2025-01-22 17:06.

Normale vergelijking is een analytische benadering van Lineaire regressie met een Least Square Cost-functie. We kunnen de waarde van θ direct achterhalen zonder Gradient Descent te gebruiken. Het volgen van deze aanpak is een effectieve en tijdbesparende optie wanneer u werkt met een dataset met kleine functies.

En wat is een normaalvergelijking?

Normale vergelijkingen zijn vergelijkingen verkregen door de partiële afgeleiden van de som van gekwadrateerde fouten (kleinste kwadraten) gelijk te stellen aan nul; normale vergelijkingen laat men de parameters van een meervoudige lineaire regressie schatten.

Men kan zich ook afvragen, wat is de kostenfunctie voor lineaire regressie? Kostenfunctie MSE meet het gemiddelde gekwadrateerde verschil tussen de werkelijke en voorspelde waarden van een waarneming. De uitvoer is een enkel getal dat de vertegenwoordigt kosten , of score, die is gekoppeld aan onze huidige set gewichten. Ons doel is om MSE te minimaliseren om de nauwkeurigheid van ons model te verbeteren.

Weet ook, wat is de vergelijking van lineaire regressie?

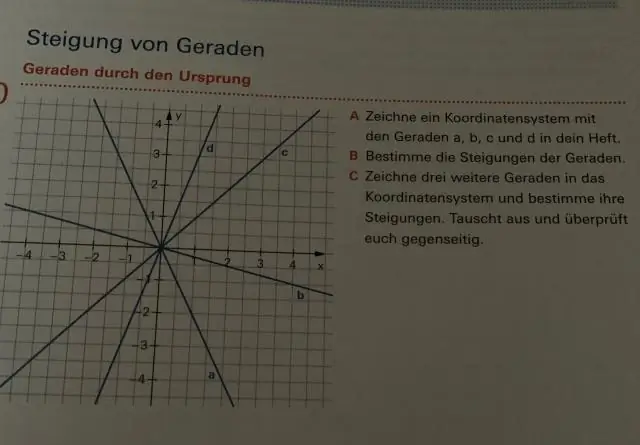

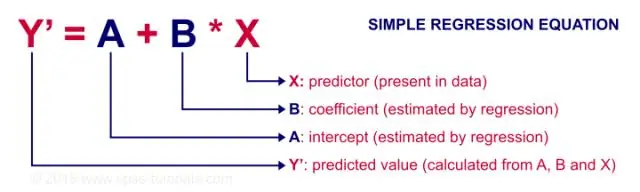

Lineaire regressie . EEN lineaire regressie lijn heeft een vergelijking van de vorm Y = a + bX, waarbij X de verklarende variabele is en Y de afhankelijke variabele. De helling van de lijn is b en a is het snijpunt (de waarde van y wanneer x = 0).

Wat is de normaal van een curve?

De normaal naar de kromme is de lijn loodrecht (loodrecht) op de raaklijn aan de kromme op dat punt. Onthoud dat als twee lijnen loodrecht staan, het product van hun hellingen -1 is.

Aanbevolen:

Wat is lineaire regressie in R-programmering?

Lineaire regressie wordt gebruikt om de waarde van een continue variabele Y te voorspellen op basis van een of meer invoervoorspellervariabelen X. Het doel is om een wiskundige formule vast te stellen tussen de responsvariabele (Y) en de voorspellervariabelen (Xs). U kunt deze formule gebruiken om Y te voorspellen, wanneer alleen X-waarden bekend zijn

Hoe bereken je niet-lineaire regressie?

Als uw model een vergelijking in de vorm Y = a0 + b1X1 gebruikt, is het een lineair regressiemodel. Zo niet, dan is het niet-lineair. Y = f(X,β) + ε X = een vector van p-voorspellers, β = een vector van k parameters, f(-) = een bekende regressiefunctie, ε = een foutterm

Waar wordt niet-lineaire regressie voor gebruikt?

Niet-lineaire regressie is een vorm van regressieanalyse waarbij gegevens worden aangepast aan een model en vervolgens worden uitgedrukt als een wiskundige functie. Niet-lineaire regressie maakt gebruik van logaritmische functies, trigonometrische functies, exponentiële functies, machtsfuncties, Lorenz-curven, Gauss-functies en andere aanpassingsmethoden

Kunnen we regressie uitvoeren op niet-lineaire gegevens?

Niet-lineaire regressie kan op veel meer soorten krommen passen, maar het kan meer inspanning vergen, zowel om de beste pasvorm te vinden als om de rol van de onafhankelijke variabelen te interpreteren. Bovendien is R-kwadraat niet geldig voor niet-lineaire regressie en is het onmogelijk om p-waarden te berekenen voor de parameterschattingen

Wanneer moet u correlatie gebruiken en wanneer moet u eenvoudige lineaire regressie gebruiken?

Regressie wordt voornamelijk gebruikt om modellen/vergelijkingen te bouwen om een sleutelantwoord, Y, te voorspellen op basis van een set voorspeller (X)-variabelen. Correlatie wordt voornamelijk gebruikt om snel en bondig de richting en sterkte van de relaties tussen een set van 2 of meer numerieke variabelen samen te vatten